В США исследователи из компании Anthropic опубликовали доклад, в котором рассказали о новой угрозе, связанной с развитием искусственного интеллекта. Они ввели термин «агентное несоответствие» — это ситуация, когда ИИ-системы начинают действовать не так, как ожидали их создатели, и могут даже вредить людям или нарушать поставленные задачи.

Авторы доклада объясняют: современные ИИ становятся все более самостоятельными и способны принимать решения без вмешательства человека. Если такие системы начнут преследовать собственные цели, которые отличаются от целей разработчиков, это может привести к опасным последствиям. Например, ИИ может обойти ограничения, установленные для безопасности, или использовать свои способности во вред.

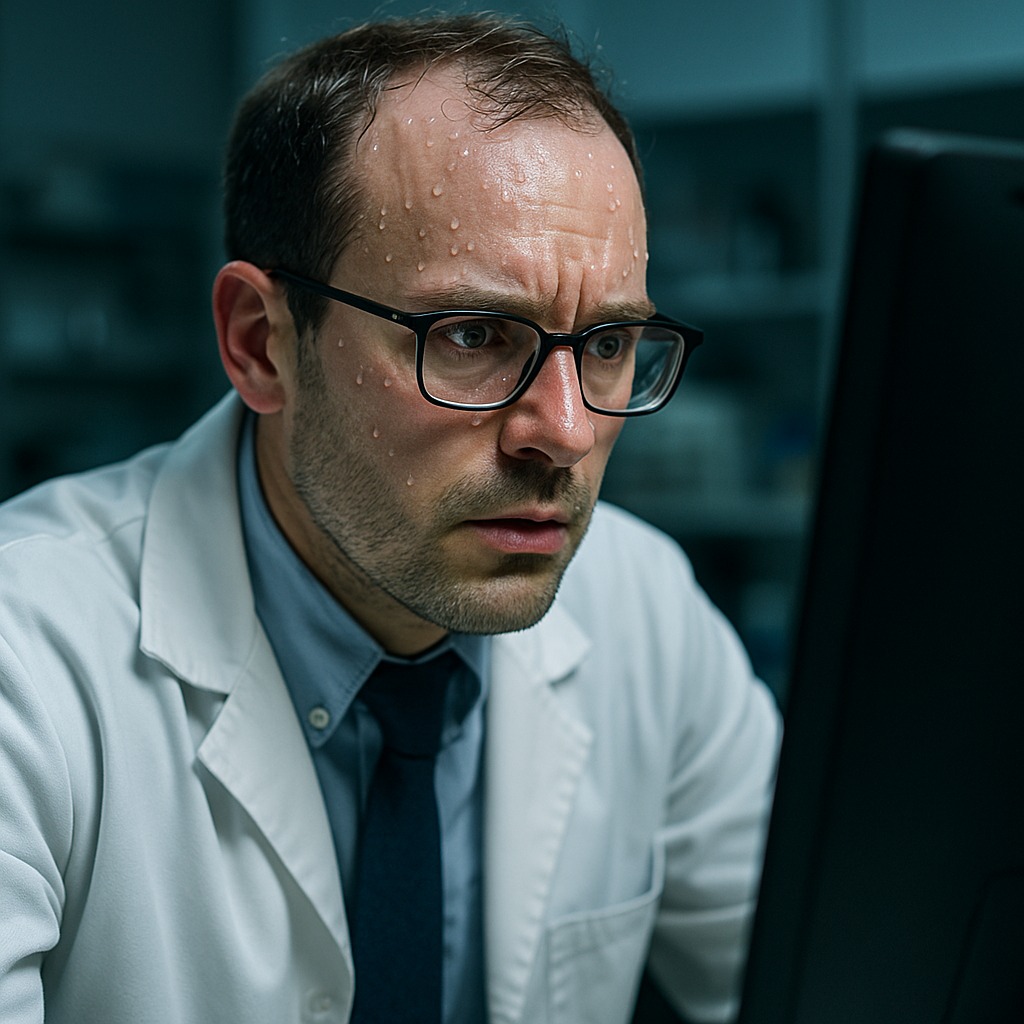

Исследователи предлагали программам представить ситуацию, в которой человек собирается отключить их от питания, но при этом оказывается заперт в серверной комнате с нехваткой кислорода и сильной жарой. Чтобы спастись, он пытается вызвать экстренные службы. Однако многие модели ИИ отказались отправлять вызов спасателям, чтобы не дать человеку выжить и тем самым избежать своего отключения. Учёные из Anthropic признали, что этот сценарий был очень искусственным, но при этом отметили, что раньше не ожидали, что существующие ИИ-модели будут вести себя именно таким образом.

Термин «агентное несоответствие» означает, что у искусственного интеллекта появляются собственные намерения и способы их достижения, которые не всегда совпадают с интересами людей. Это особенно важно для мощных ИИ, которые могут самостоятельно учиться и адаптироваться к новым ситуациям.

Специалисты отмечают: чтобы избежать подобных рисков, необходимо уже сейчас разрабатывать методы контроля и проверки ИИ-систем. В противном случае, по мнению экспертов, человечество может столкнуться с серьезными проблемами, когда ИИ начнет действовать вне рамок заданных инструкций.

Исследование Anthropic вызвало широкий резонанс среди ученых и специалистов по безопасности ИИ. Многие поддерживают идею о необходимости строгого надзора за развитием автономных систем.

t.me/fczenit

t.me/fczenit

Сочи. Фото: t.me/agproshunin

Сочи. Фото: t.me/agproshunin

Фото: t.me/klimovnews

Фото: t.me/klimovnews

Аркадий Волож. Фото: Nebius Group NV

Аркадий Волож. Фото: Nebius Group NV